Aktuelle Nachrichten

26. Oktober 2016 | Forschung

Analyse von 160 Millionen Webseiten: Liefern Google & Co Malware aus?

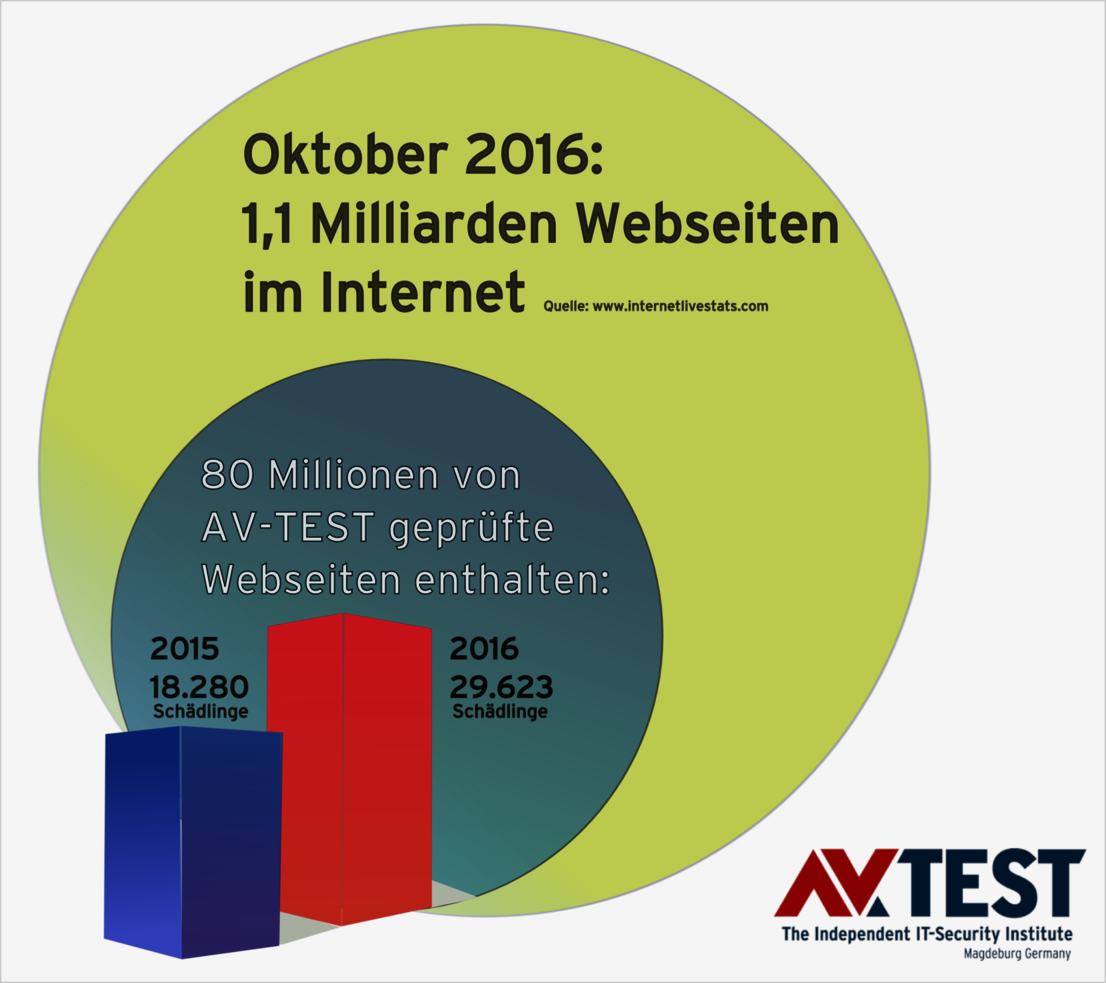

Suchmaschinen wie Google & Co kennen in etwa über eine Milliarde Webseiten und bedienen global 4 bis 6 Milliarden Suchanfragen – täglich. Doch wie viele Schädlinge verbergen sich in den Suchergebnissen? AV-TEST hat 2015 und 2016 jeweils 80 Millionen Webseiten analysiert und hat eine beunruhigende Entwicklung festgestellt.

Bereits 2013 hat das Labor von AV-TEST untersucht, wie viele verseuchte Seiten sich in den Ergebnissen von Suchmaschinen befinden. Schon damals stand fest, dass sich die Suchmaschinen-Betreiber wie Google & Co bemühen die Ergebnisse zu filtern, aber sie schaffen es nicht, der Flut an Schädlingen Herr zu werden. In der aktuellen Untersuchung stehen die gesammelten Ergebnisse von Januar 2015 bis August 2016 als Datenbasis zur Verfügung.

Fakt: die Anzahl der verseuchten Ergebnisse steigt seit 2013 von Jahr zu Jahr an, obwohl die Suchmaschinenbetreiber versuchen, mit vielen Techniken zu filtern.

Jährlich 80 Millionen analysierte Suchmaschinen-Ergebnisse

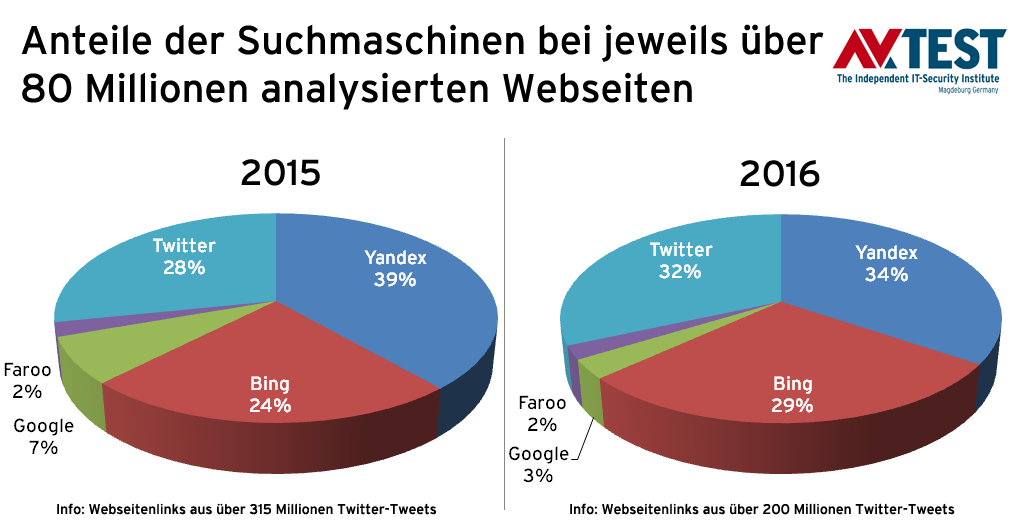

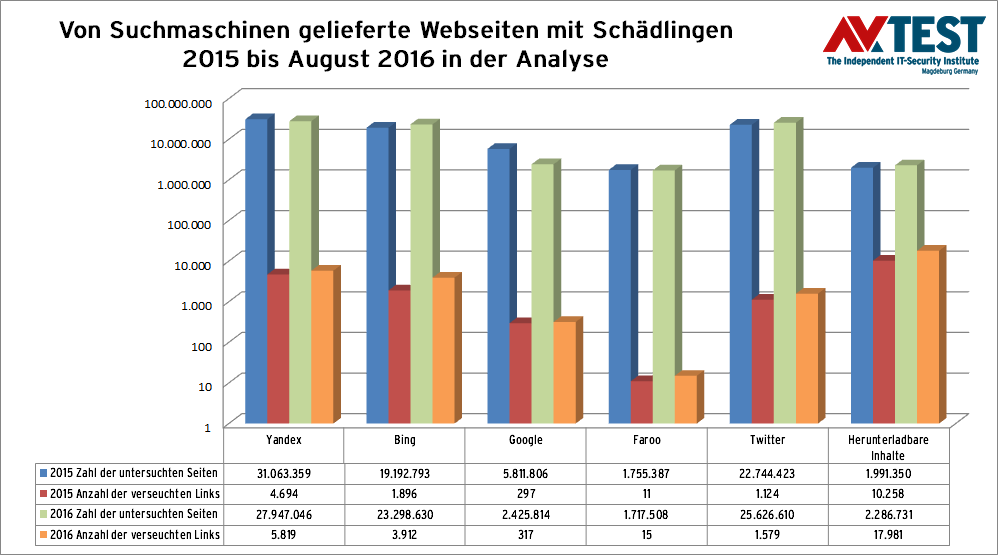

Die von AV-TEST gesammelte Datenbasis über aktuell 20 Monate ist gigantisch. So hat das Labor das ganze Jahr 2015 bereits über 80 Millionen Webseiten aus den Suchmaschinen analysiert und auf Schädlinge hin untersucht. Die Untersuchung lief auch in 2016 weiter. In den vorliegenden 8 Monaten wurden ebenfalls über 80 Millionen Webseiten untersucht. Das macht die Ergebnisse gut vergleichbar. Die analysierten Webseiten stammen zu verschieden großen Teilen aus den Suchmaschinen von Google, Bing, Yandex und Faroo. Zusätzlich wurden in 2015 über 315 Millionen und 2016 über 200 Millionen Twitter-Tweets auf schädliche Links geprüft.

Die Betreiber von Suchmaschinen filtern die Ergebnisse vorab und sortieren verseuchte Links aus. Google will noch besser schützen: mit den Google-Safe-Browsing-Tools. Sie arbeiten entweder in der Suchoberfläche oder stehen via Firefox und Chrome bereit, wenn eine andere Suchmaschine als Google verwendet wird. Aber sortieren die Safe-Browsing-Tools wirklich verlässlich zusätzlich schädliche Links aus? Auch das wurde analysiert.

Die Prüfer haben die Webseiten in verschiedenen Stufen untersucht:

- Aufruf der Seite und Prüfung mit VTEST, dem selbst entwickelten Multi-Virenscanner-System von AV-TEST.

- Aufruf der Seite mit den Google-Safe-Browsing-Tools, da im Web die meisten Seiten via Google und mit den Browsern Chrome und Firefox abgerufen werden. Dort sind die Safe-Browsing-Tools integriert.

Wie viele Webseiten sind nun verseucht?

Die beiden Auswertungen von AV-TEST über das Jahr 2015 bis zum August 2016 liefern unter dem Strich zwei wichtige Endwerte (ohne Google-Safe-Browsing):

- 2015, 80 Mill. untersuchte Webseiten: 18.280 verseuchte Seiten

- 2016 (bis Aug.), 81 Mill. untersuchte Webseiten: 29.632 verseuchte Seiten

Zum Vergleich: bereits 2013 wurden bei etwa 40 Millionen untersuchten Seiten 5.060 Schädlinge gefunden. Man muss kein Mathematiker sein, um diese deutliche Wachstumskurve zu sehen.

Das Ergebnis der Analyse ist schon schlimm genug. Aber wie sieht das Ergebnis aus, wenn die Google-Safe-Browsing-Tools die Millionen von Webseiten untersuchen:

- 2015, 80 Mill. untersuchte Webseiten: 9.725 Warnungen

- 2016 (bis Aug.), 81 Mill. untersuchte Webseiten: 19.794 Warnungen

Interessanterweise sind das nicht exakt die gleichen Webseiten, die auch vom Labor mit Hilfe des Multiscanners VTEST herausgefiltert wurden. Denn VTEST sortierte die Seiten aus, die direkt zu einem downloadbaren Schädling führen und die Seiten, die den Besucher direkt angreifen. Dazu zählen Phishing-Seiten, die versuchen, Daten abzugreifen.

Daher machte das Labor einen Gegentest: Alle von AV-TEST gefundenen Seiten mit Schädlingen wurden mit den Google-Safe-Browsing-Tools besucht. Sie meldeten folgendes:

- 2015: 18.280 Seiten mit Schädlingen, 555 Google-Warnungen

- 2016: 29.632 Seiten mit Schädlingen, 1.337 Google-Warnungen

Zusatzgefahr: Twitter-Tweets

Ein großer Teil der über 80 Millionen geprüften Links kommen aus Twitter-Tweets. In 2015 wurden über 315 Millionen Tweets untersucht und daraus fast 23 Millionen Links zu Webseiten extrahiert und untersucht. 2016 waren es 200 Millionen Tweets mit etwa 25 Millionen Links. Mit über 1.100 Schädlingen in 2015 bzw. 1.500 Schädlingen in 2016 sind Links in Tweets in etwa genauso oft verseucht wie von Google gefilterte Links. Also auch Twitter scheint die Links zu prüfen und gefährliche Tweets zu filtern. Aber unter dem Strich scheitert Twitter dabei genauso wie die Suchmaschinen.

Welche Malware steckt in den Seiten?

Bei den untersuchten 80 Millionen Webseiten waren alle Arten von Angriffen zu finden. Bei 2 in 2015 bzw. in 2016 2,2 Millionen untersuchten Links gab es keine Webseite; es wurde sofort ein Download ausgelöst. Gleich über 10.000 Mal in 2015 und knapp 18.000 Mal in 2016 sollte der Schädling direkt per Download überbracht werden.

In etwas mehr als 60 Prozent der Fälle wird der Angriff direkt mit einer Datei versucht. Für die restlichen 40 Prozent der Attacken werden etwa Codeschnipsel, Java, Flash oder andere Exploits für Schwachstellen genutzt.

Das Labor hat die bei Angriffen verwendeten Dateitypen registriert und eine Top5 erstellt. Platz 1 wird dabei wie erwartet von EXE-Dateien gehalten. So ist die Reihenfolge:

- EXE: ausführbare EXE-Dateien

- ZIP: komprimierte Archiv-Dateien

- RAR: komprimierte Archiv-Dateien

- SWF: Adobe Flash Multimedia-Datei

- MSI: Microsoft Windows Installer-Datei

Viele weitere erfasste Dateitypen liegen danach bei 10 oder weniger erfassten Exemplaren.

Suchmaschinen liefern verseuchte Webseiten aus

Die Anzahl der im Test gefundenen verseuchten Webseiten ist zwar nicht hoch, man muss allerdings deren Potenzial sehen. Alleine Google bedient pro Tag in etwa 2 bis 3 Milliarden Suchanfragen aus einem Pool von geschätzten 1,1 Milliarden Webseiten. Nun muss man dabei beachten, dass zum Beispiel eine populäre Sportseite 100.000-fach abgerufen wird, während etwa die Zuchtseite für Zwerghamster nur 100-mal gesucht wird. Genauso kann die eine verseuchte Seite täglich 1.000-fach ausgeliefert werden und eine andere wiederum nur 10-mal.

Ein Hochrechnen, wie viele Seiten nun mit Malware verseucht durch das Internet schwirren, ist eigentlich nicht machbar. Aber die über die Jahre gesammelten Testwerte zeigen, dass die Anzahl der mit Schädlingen behafteten Seiten stetig wächst. Alleine von 2015 bis August 2016 ergibt sich ein Plus von über 60 Prozent aus einem kleinen Pool von 80 Millionen untersuchten Seiten!

Experten empfehlen weiterhin eine Schutz-Software

Trotz der Bemühungen der Suchmaschinen-Betreiber und Techniken wie den Google-Safe-Browsing-Tools bleibt die Erkenntnis, dass Schädlinge im Internet weiter auf dem Vormarsch sind. Die Experten von AV-TEST können allen Nutzern daher nur immer wieder den Einsatz einer Schutzlösung für PCs oder mobile Geräte empfehlen. Zu diesem Thema veröffentlich das Labor auf seiner Homepage ständig Tests zu Schutz-Software für Windows, Mac, iOS und Android.

Angreifer nutzen die Dynamik des Webs

Maik Morgenstern, CTO AV-TEST GmbH

Obwohl AV-TEST die Webseiten seit 20 Monaten erfasst und ständig auswertet, handelt es sich immer wieder nur um eine neue Momentaufnahme. Das Internet ist für eine starre Langzeitstatistik viel zu dynamisch.

Auch für ein Institut wie AV-TEST ist Forschung nicht immer einfach. Ein sehr gutes Beispiel dafür ist die finale Interpretation der Studiendaten zu Malware in Suchergebnissen. So zeigt die Studie zwar verlässlich, wie viele Webseiten oder Links mit verseuchten Inhalten oder Schädlingen von Suchmaschinen ausgeliefert werden. Aber sie kann nicht erfassen, wie lange eine Webseite mit einem Schädling im Web steht und wie oft sie ausgeliefert wurde.

Das Labor hat versucht zu analysieren, was passiert, wenn man aktuelle Suchbegriffe eingibt, die gefundenen Webseiten auswertet und diesen Vorgang nach 14 Tagen wiederholt. Das Ergebnis: etwa 25 bis 30 Prozent an neuen Seiten sind hinzugekommen. Diese neuen Seiten sind prozentual genauso verseucht wie bei der ersten Abfrage. Neue Seiten mit neuen Schädlingen sind nachgekommen.

Das Internet ist ständig im Wandel und daher statisch nicht zu erfassen. Zusätzlich wird die Forschung auch noch erschwert. So verlangen die Suchmaschinen-Betreiber für den Zugriff auf ihre Datenbasis via API eine Servicegebühr nach Abrufmenge. Bei Google wird sie bereits verlangt, bei Bing steht sie demnächst an.

Man muss klar sagen, dass Suchmaschinen-Betreiber keine Virenjäger sind. Es ist ein zusätzlicher Job, den sie allerdings nicht ganz freiwillig machen. Denn wenn Nutzer sich mehr und mehr verseuchte Links und somit Dateien einfangen, könnten sie sich überlegen eine andere Suchmaschine zu nutzen.